Science合作期刊Intelligent Computing发表新论文,中国科学院计算所徐志伟教授牵头组织的“低熵云计算”专辑正式出版,收入了来自中国科学院计算所、中国科学院深圳先进技术研究院、香港中文大学、鹏城实验室、天津大学等单位的五篇投稿,得到了孙凝晖院士、陈云霁研究员、包云岗研究员等知名学者的支持,系统的介绍了“低熵云计算”的技术内涵。此外,西安电子科技大学韩根全教授及其合作者发表用于智能计算的铁电器件相关综述,郝跃院士作为共同作者参与了论文发表。

“低熵云计算”专辑简介

传统的云计算系统常常存在高熵问题,究其原因是云计算系统中存在的三类无序现象:负载干扰、系统抖动和阻抗不匹配。这种无序混乱使当前云计算系统难以同时满足高利用率和低延迟的要求。应用程序经常需要超额占有云资源,有时甚至超出实际需要的数倍以保障其服务质量。而超额申请的资源往往会成为滞留资源,虽然从未使用过,但也不能分配给其他应用程序,极大地拉低了数据中心的资源利用率。

Science合作期刊Intelligent Computing发表新论文,中国科学院计算所徐志伟教授牵头组织的“低熵云计算”专辑正式出版,收入了来自中国科学院计算所、中国科学院深圳先进技术研究院、香港中文大学、鹏城实验室、天津大学等单位的五篇投稿,得到了孙凝晖院士、陈云霁研究员、包云岗研究员等知名学者的支持,系统的介绍了“低熵云计算”的技术内涵。此外,西安电子科技大学韩根全教授及其合作者发表用于智能计算的铁电器件相关综述,郝跃院士作为共同作者参与了论文发表。

“低熵云计算”专辑简介

本期专辑中的五篇论文介绍了低熵云计算的进展,提出了一个解决上述高熵问题的新概念系统。低熵云计算系统包括:可以在硬件层实现区分、隔离和优先化(DIP)约束的标签化处理器架构、提供10倍速增长的标签化网络栈、可以显著降低尾延迟的用于配置自动调优的机器学习方法、可以用控制模式约束限制编程熵的分形并行模型 (FPM)、以及新的基准套件SDCBench。这些论文涉及系统基准测试和熵测量、处理器架构、系统软件、应用程序框架和各种工作负载的评估结果。上述技术内容共同表明,低熵云计算技术可以同时增强用户体验和资源利用率。

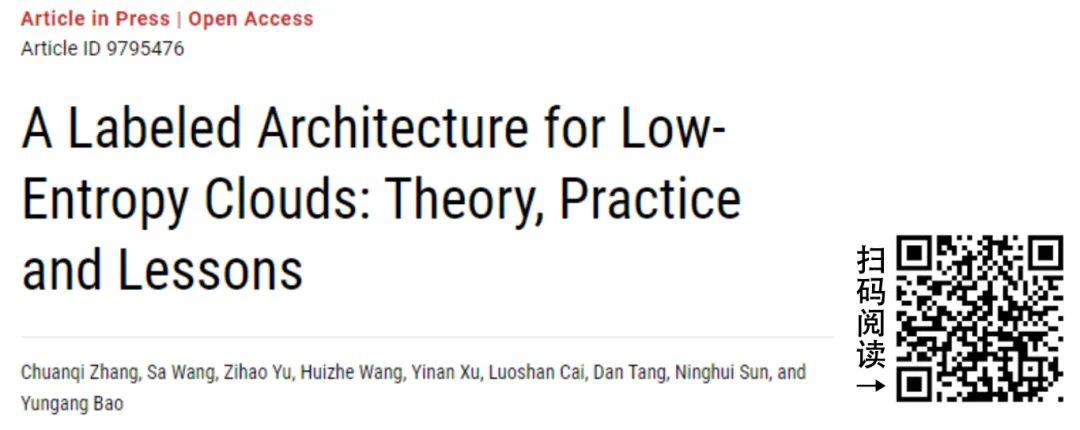

1. 一种支持低熵云的标签化体系结构:理论、实践与经验

在过去的十年中,资源效率和服务质量(QoS)都是云计算供应商长期追求的目标。然而,直到今天,几乎没有一个云平台能够完美兼顾这些目标。提高资源效率或资源利用率通常会导致云应用在不同资源上(从底层硬件到软件堆栈)发生复杂的资源竞争,从而导致严重的性能下降。低熵云系统提出了一种新的软硬件协同技术栈,从下至上全面降低性能干扰,同时获得高资源效率和高质量的应用性能。

本文介绍了一种新的支持低熵云的计算机体系结构,称为标签化冯诺依曼体系结构 (LvNA, Labeled von Neumann Architecture),该架构在计算机系统内部集成了一套标签驱动的控制机制,能够在系统共享资源上实现区分、隔离、优先处理应用程序请求。利用标签化机制,LvNA能够在提高资源利用率的同时,保护特定应用 (如延迟敏感型应用)的性能不受无序资源竞争的影响。基于LvNA的设计,我们流片了一个1.2GHz 8核RISC-V处理器BEIHAI。实验结果表明,BEIHAI能够将内存带宽竞争导致的性能下降从82.8%大幅降低到0.4%。当CPU利用率提高70%以上时,BEIHAI可以将延迟敏感型应用Redis的99分位延迟从115 ms降低到18.1 ms。此外,BEIHAI还可以实现无需软件Hypervisor支持下,同时启动两个未修改的虚拟机。

图一:LvNA的标签驱动控制机制

2. 基于排队理论的低熵标签化网络栈的性能分析

理论建模是对计算机系统进行量化分析和性能预测的一种流行的方法,同样适用于云计算系统。随着云计算系统的发展,“低熵云”正在成为一种新的趋势。基于LNS (Labeled Network Stack)的服务器是“低熵云”的一个范例,它的性能比基于传统网络栈的服务器有数量级的提升。但我们仍需弄清:1)相对于学术界典型的用户态协议栈mTCP和工业界主流的Linux内核协议栈,LNS的低尾延迟和低熵的主要来源是什么;2) LNS还可以进一步优化多少。为此,我们提出了一种定义瓶颈阶段的排队论分析方法来简化尾延迟的量化分析。在该分析方法的指导思想下,我们以突发流量为例,使用非侵入式的基础测试获取网络服务各阶段处理速度,基于负载和系统特征识别处理速度最慢的瓶颈阶段,对基于LNS的服务器、基于mTCP的服务器和基于Linux的服务器分别建立了能感知阶段处理速度变化的模型。模型揭示,全路径优先化处理和全程零拷贝是基于LNS的服务器的低尾延迟和低熵的主要来源,其99分位尾延迟与实际测量的误差范围在0.8%–24.4%。此外,基于LNS的服务器的模型可以提供访问数据库的最佳工作线程数,使其并发度提高了2.1–3.5倍。

图二:瞬时突发请求的数量对所建模的三台服务器的99分位尾延迟的影响。“LNS”、“mTCP”和“Linux”代表延迟敏感请求的99分位尾延迟的测量值;“-model”后缀代表模型预测值;“-1”后缀代表全部的请求。

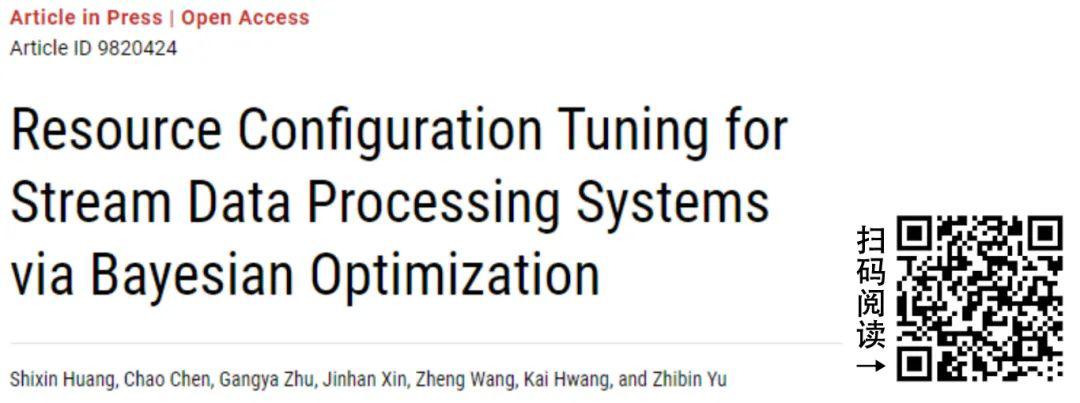

3. 基于贝叶斯优化的流数据处理系统资源配置调优

大数据时代,流数据处理系统越来越受欢迎。像Apache Flink这样的流处理系统通常会提供一定数量(比如30个)的配置参数来灵活地指定分配给任务的资源数量(比如CPU核数和内存大小),这些参数对任务性能有较大影响。但是,对于运行在给定集群上的未知程序,手动对这些参数进行调优以获得最佳性能是很困难的,因此需要一种自动且快速的资源配置调优方法。为此,我们提出利用贝叶斯优化方法来自动对流数据处理系统的资源配置进行调优。我们首先选择一个机器学习模型—随机森林,来为流数据处理程序构建精确的性能模型。随后,我们使用贝叶斯优化(BO)算法,结合性能模型,通过迭代搜索得到流数据处理程序的最优配置。实验结果表明,对于第99个百分位的尾延迟,该方法平均提高了2.62倍,最大提高了5.26倍。此外,对于程序的吞吐量,我们的方法平均提高了1.05倍,最大提高了1.21倍。

图三:所有程序 — WordCount (WC),Identity(ID),RePartition(RP)和FixWindow (FW)的性能比较 — 默认配置(DEF):贝叶斯优化算法(BOA)和改进的爬山法(MHC).

4. 分形并行计算

随着机器学习(ML, Machine Learning)技术的兴起,云、边、端一系列应用场景需要开发各种规模的专用ML计算机。然而,传统ML计算机异构、并行和多层次的特性使得开发成本集中在了软件栈上(例如ML框架、计算库和编译器),限制了新型ML计算机的研发。在前期工作中,我们提出了分形冯·诺伊曼体系结构(FvNA, Fractal von Neumann Architecture)来解决ML计算机的编程效率问题。FvNA在编程时具有规模不变性,因此在一系列不同规模尺度的ML计算机上开发软件就如同在单节点计算机上开发一样简单。

本研究将FvNA向通用并行计算领域推广。我们将FvNA建模为一个抽象的并行计算模型,称为分形并行机(FPM, Fractal Parallel Machine)模型,随后展示了几个典型的通用领域并行计算任务在FPM上的高效编程实现。FPM通过对并行计算系统的控制模式施加额外约束来降低并行程序的熵;尽管如此,FPM仍然具有通用性,并且在许多情况下能够以最优开销完成任务。初步结果表明,FPM与许多基本的并行计算模型(如BSP和交替图灵机)一样强大。因此,我们得以说明FvNA也普遍适用于ML以外的各种领域

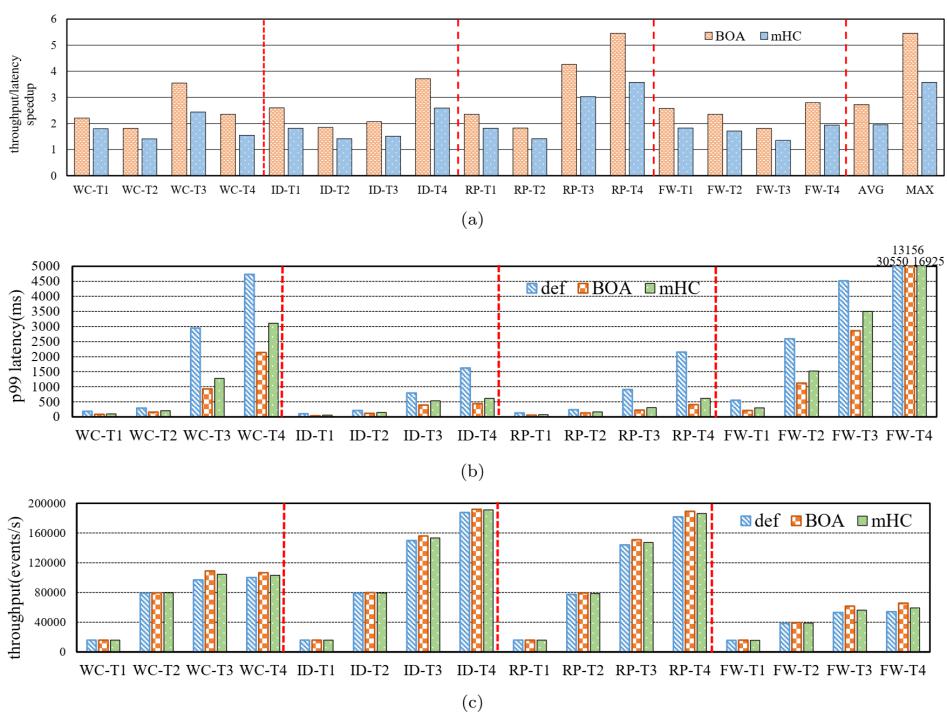

5. SDCBench:用于数据中心工作负载托管和评估的基准套件

数据中心通常通过工作负载的混部来提高系统资源利用率。然而,共享资源争用会导致难以预测的应用程序性能下降,从而制约混部技术所带来的效益改善。如何提高数据中心的隔离能力这一问题在近年来引发了一系列硬件和软件技术的相关研究,目前仍然缺乏一个全面的基准测试套件来评估这些方法。

为了解决这个问题,我们提出了SDCBench,一个专门面向数据中心负载混部和刻画而设计的新的基准评测套件。SDCBench基于聚类分析方法从现有的基准评测程序集中精心挑选了16个基准应用程序,能够覆盖各类常见的云业务场景。SDCBench利用一套统计学方法来支持工作负载的混部和评测,并首次提出了延迟熵的概念来衡量云计算系统的隔离能力。SDCBench能够帮助云租户了解数据中心的性能隔离能力,从而选择最适合自身业务的云服务。SDCBench也有助于云服务器提供商其改善产品服务质量,增加运营收入。实验结果表明,SDCBench可以通过简单的操作和配置来对多种维度的资源施加压力,从而模拟多样化的云负载混部场景。我们还基于SDCBench对华为云、AWS云和低熵云原型系统FlameCluser-II三个平台进行了应用延迟熵的对比,评估结果表明FlameCluser-II在三种云系统中具有最好的性能隔离能力,达到了较低的延迟熵水平。

图四:SDCBench总览

用于智能计算的铁电器件

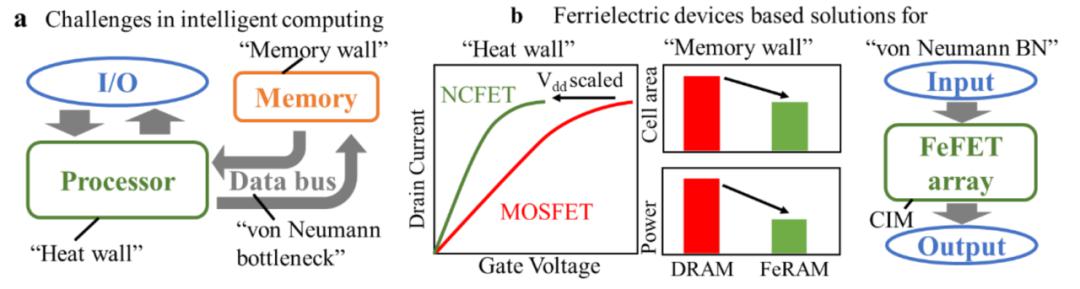

晶体管的缩小正在接近其物理极限,阻碍了计算能力的进一步发展。在后摩尔时代,新兴的逻辑和存储器件已经成为扩展智能计算能力的基本硬件。本文回顾了用于智能计算的铁电器件的最新进展,阐明了铁电器件的材料特性和电学特性,随后讨论了可用于智能计算的新型铁电材料和器件。作者对用于低功耗逻辑、高性能存储器和神经形态应用的铁电电容器、晶体管和隧道结器件进行了全面的回顾和比较。此外,为了给开发基于铁电的高性能智能计算系统提供有益的指导,作者总结讨论了实现用于高效计算的超大规模铁电器件的关键挑战。

图五:(a)使用冯·诺伊曼架构的现代计算机面临的挑战 (b)基于铁电器件的“热墙”,”内存墙”和冯·诺伊曼瓶颈的解决方案示意图

文章来源:新智元

IEEE Spectrum

《科技纵览》

官方微信公众平台