你的意图是什么?

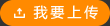

工程人员展示了一款用于汽车的神经网络芯片,该款芯片可以预测出汽车撞上行人的风险。

-----工程人员正尝试将占用较大空间的人工智能塞入移动系统。

近些年来,基于神经网络的人工智能系统取得了一系列显著成功:有在围棋比赛中击败人类顶尖棋手的,有自动生成啤酒评论的,还有营造迷幻艺术的。可是,让这些极度复杂且耗电量超高的系统走入现实世界并安装在便携式设备中却绝非易事。然而,在今年2月份于旧金山召开的IEEE国际固态电路会议上,来自麻省理工学院、英伟达和韩国科学技术学院(KAIST)的团队却用自己的成果证明,人类距离实现这一目标又近了一步。他们在大会上展示了用来运行人工神经网络的低功率芯片的原型,借助这些芯片,智能手机将能够自行判断看到的内容,自动驾驶汽车将可以预测行人的行动,如此等等。

到目前为止,神经网络——这种运行方式与彼此连接的脑细胞构成的网络非常相似的学习系统——一直因其巨大的能耗而无法在那些可以从人工智能中受益最多的移动设备(例如智能手机、小型机器人和无人机)上运行。人工智能移动芯片在提高自动驾驶汽车智能水平的同时也只能以耗尽其电池电量为代价或在燃料经济性方面作出妥协。

智能手机的处理器很快便可以将某些强大的神经网络作为软件在手机上运行。高通公司正将其下一代骁龙智能手机处理器连同一个软件开发包一起提供给手机制造商,以便利用神经网络开展自动图像标注。这种专注软件的设计方案可谓一项里程碑式的成就,但同时也有它的局限性。例如,手机的应用程序无法自己学习任何新内容——它只能通过性能更加强大的计算机接受相应培训。同时,神经网络专家认为,如果他们可以使电路本身拥有一些神经网络的友好特征,那么便有可能实现更复杂的功能。

麻省理工学院的电气工程教授维维安•施(Vivienne Sze)介绍说,神经网络越大,其计算层便越多,运行过程消耗的能量便越多。无论其应用领域如何,主要的电源消耗都源自数据在处理器和内存之间的转移。对用于进行图像分析的卷积神经网络而言,这个问题尤其突出。(名称中的“卷积”一词暗示涉及的众多步骤。)

对于人脑而言,提取记忆建立联想是个很自然的过程。一个3岁的小孩都可以轻松地指出图片中的图像是一只猫躺在床上。卷积神经网络也可以将图像中的所有物体进行分类。首先,像图像识别模型AlexNet这样的系统会找到图片中物体的边缘,然后开始逐一地识别这些物体——猫、床、毯子,最终推断出图像中是一个室内场景。然而,即便是完成这样简单的分类作业,也需要消耗极高的能量。

神经网络,特别是用于图像分析的神经网络大多运行于图形处理单元(GPU),而骁龙处理器也是通过GPU实现其场景探测功能的。维维安•施表示,GPU在图像处理方面已经非常专业了,但若要制造出可以有效运行神经网络的电路,可做的事情还有很多。

维维安•施与麻省理工学院的计算机科学教授兼英伟达资深杰出研究科学家祖尔•艾默(Joel Emer)合作开发出首款可运行最前沿的卷积神经网络的定制芯片——Eyeriss。他们展示的这款芯片仅以普通移动GPU十分之一的能耗便可运行AlexNet这一计算量非常庞大的算法:普通手机GPU的能耗在5至10瓦之间,而Eyeriss只需要0.3瓦。

维维安•施和艾默合作开发的这款芯片之所以能够节省能耗,是因为他们在168个处理引擎中每一个的旁边都放置了一个专用存储体。这样一来,芯片便可以尽可能少地从一个较大的主存储体中获取数据。除此之外,Eyeriss还将其传送的数据予以压缩,并通过一些统计手法省略掉了GPU通常采用的某些步骤。

KAIST教授兼该学院下属的多媒体超大规模集成电路(VLSI)实验室的负责人金利燮(Lee-Sup Kim)表示,这些为神经网络驱动的图像分析所制造的电路还可用于机场的人脸识别系统以及机器人导航。在这次会议上,金利燮教授的实验室展示了一款可作为物联网通用视觉处理器使用的芯片。与Eyeriss类似的是,KAIST的这款设计也是通过拉近存储和处理单元之间的距离实现数据移动最小化。这款芯片的能耗只有45毫瓦,当然,公平来说,它所运行的网络远没有Eyeriss那么复杂。芯片通过限制数据移动和减轻计算量的方式降低能耗。金利燮教授团队发现,在关键计算中所用到的99%的数字只需要8比特,所以他们才得以对计算资源加以限制。

英伟达的艾默教授表示:“在通用性和效率之间作选择是一个很大的挑战。”维维安•施、艾默和金利燮教授都正在尝试制作用于图像分析的通用神经网络芯片,即一种神经网络处理单元(NNPU)。而另一位来自KAIST的教授、系统设计创新和应用研究中心的负责人柳会峻(Hoi-JunYoo)则倾向于采用更加专业的应用驱动方式制作神经网络硬件。

在柳会峻教授所描述的系统中,有一种是为自动驾驶汽车设计的。这种系统可以运行能够识别视野范围内的各种物体的卷积网络,同时还可以使用一种不同的算法——递归神经网络。“递归”是指系统的一种时间技能,擅长分析随时间推移而不断变化的各种视频、语音及其他信息。柳会峻教授的团队尤其希望开发一款运行递归神经网络的芯片,用以追踪移动物体并预测其意图:人行道上的那个行人是否要进入车行道?这套能耗为330毫瓦的系统可一次性预测20个物体的意图,而且几乎可以实时作出判断——时间仅滞后1.24毫秒。

与麻省理工学院团队开发的芯片相比,柳会峻教授的这套系统的另外一个不同之处在于,它的硬件部分——也就是被柳会峻教授称为意图预测处理器的部分——能够在途中继续学习。柳会峻教授的设计中集成了一套被其命名为深度学习内核的电路,专门用于增加神经网络的训练机制。对于卷积神经网络而言,这种深度学习训练往往在功能强大的计算机上进行。但柳会峻教授表示,我们的设备应该能够适应我们的需求,并在使用过程中不断学习。“为所有事件进行预先编程是不可能实现的。现实世界变化多端,几乎完全不可预测。”柳会峻教授如是说。

作者:KatherineBourzac